En dan heb ik het over week 0 van 52 weken. 52 weken waarin ik ga kijken wat er nodig is om in mijn eigen leven m’n relatie met “Big Tech” radicaal om te vormen. Ik wil niet meer de afhankelijke positie hebben, waarin apps en websites mij iets voorschotelen, of adviseren of aansturen op basis van een black box, met algoritmes en scripts die mij steeds beter leren kennen dankzij steeds meer data die over mij wordt opgeslagen. Dat is een dilemma waar velen mee worstelen, want het is lastig om een alternatief te vinden voor allerlei toepassingen of systemen die zich nuttig maken, en goed en zelfs steeds beter functioneren. Ik vind dat allemaal nog wat extra zorgelijk omdat het moment steeds dichterbij komt waarop we de gehele dag door met een AR bril gaan rondlopen, ik wel in elk geval. Misschien dat dat aanvankelijk niet eens een bril zal zijn die draait om ruimtelijke AR vertoningen, daar spelen nog wat haken en ogen. En omdat niet iedereen een montuur op de neus wil, is het niet ondenkbaar dat we ook de optie gaan krijgen om rond te gaan lopen met een piepklein cameraatje dat de gehele dag met ons meekijkt. Niet zozeer om een complete videoregistratie te maken van ons leven, zoals in science-fiction films en series. Maar wat die camera’s wel gaan doen is het beeld analyseren met steeds slimmere computer vision algoritmes. En wat daar uitkomt, dat wordt wel opgeslagen en bewaard. Waar we zijn, wat we zien, wat we doen, wie we ontmoeten. Mark Zuckerberg hoeft niet eens meer af te wachten of we misschien op ‘like’ gaan klikken als iets ons bevalt. Als tegenover ons iemand lacht om onze grap, wordt dat gedetecteerd en gaat dat ook rechtstreeks richting de cloud. Dat gaat een enorme hoeveelheid extra data opleveren over ons en onze omgeving, waardoor het voor AI scripts nog beter mogelijk wordt om ons goed te begrijpen en ons feilloos aan te sturen. Als je daar over 10 jaar nog aan wilt ontsnappen, wordt dat moeilijk omdat je dan 10 jaar aan datavergaring achterloopt. Dat haal je nooit meer in. Tenzij je nu alvast begint met het aanleggen van je eigen data verzameling. Je download periodiek je google maps timeline. Of je gebruikt een open source GPS tracker om die data te verzamelen. Voeg er ook geregeld een dump aan toe van alle data uit je fitness tracker. En je kliks en keuzes op youtube of netflix. En zelfs al zijn al die datasets incompatibe, en is er vooralsnog niet een toepassing die er iets mee kan, toch downloaden. Want niet al starten met het sprokkelen van data is een slecht idee. Wat als een partij die jouw data beheert over een paar jaar de stekker eruit trekt, en je te laat was met downloaden? Nu alvast doen dus. En wat dan een volgende stap kan zijn: geleidelijk overschakelen op diensten die niet ingericht zijn op het verzamelen van jouw data om je zo goed mogelijk te doorgronden. Dat de cloud jou zo feilloos snapt, daar wil je van af. Want eigenlijk is het onwenselijk dat je niet weet welke software daar wordt gebruikt om je data te verwerken en een profiel op te stellen. Die keuze wil je zelf kunnen maken. Die mogelijkheid komt binnen handbereik zodra je over voldoende eigen data beschikt. Dan kun je ook je eigen AI scripts gaan draaien, op je eigen dataset. Dan kan de buitenwereld aankloppen bij jouw zogeheten “API”. Dan kan Big Tech vragen of je ergens interesse in hebt, in plaats van je vertellen dat je iets wilt.

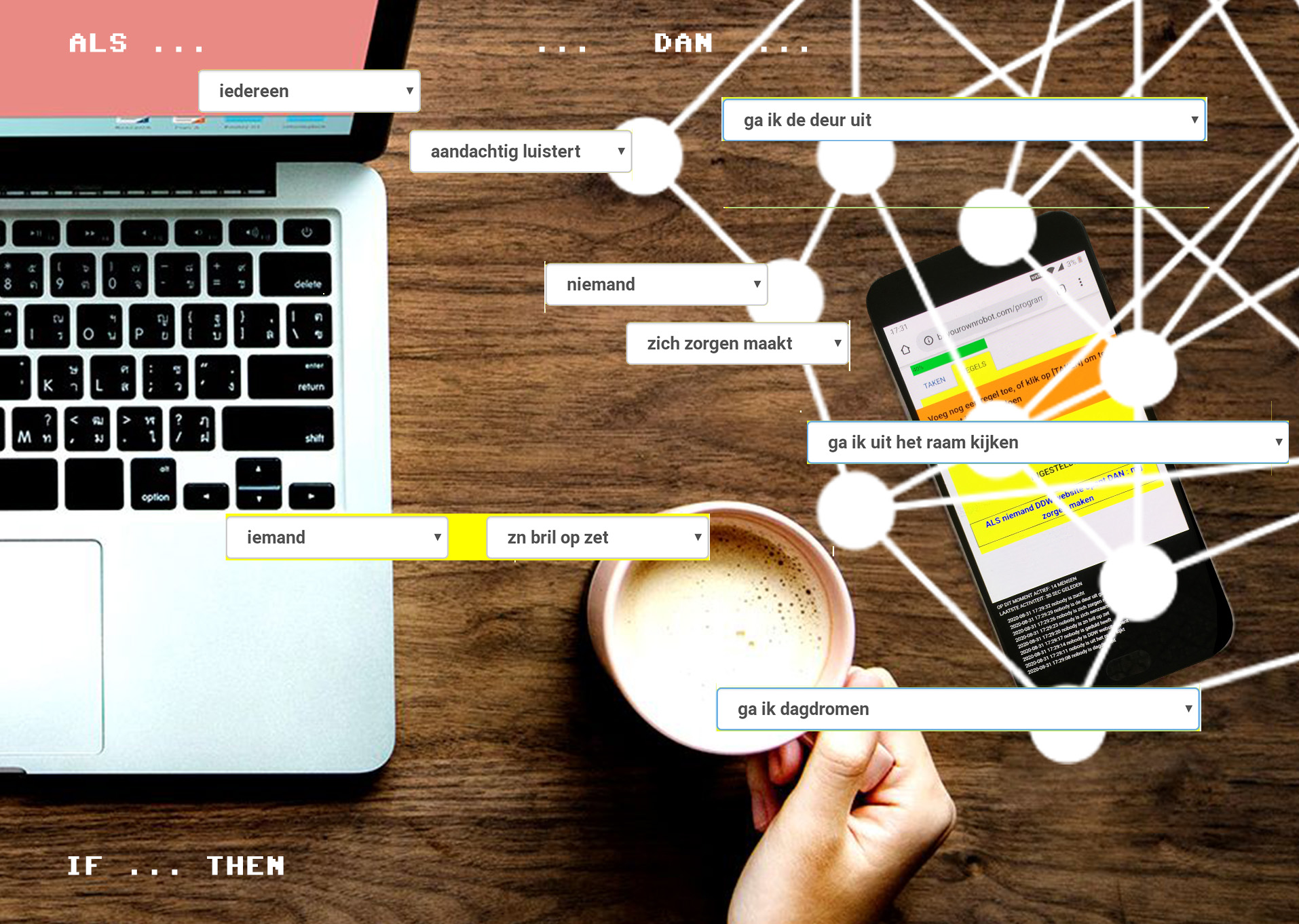

Best een flinke reeks nieuwe termen misschien, die komen nog stapsgewijs uitgebreid aan de orde de komende 52 weken. Maar de radicale stap, de gedachtestap is bij deze gemaakt: ik ga in elk geval voor mijzelf kijken hoe ver ik kom met het herinrichten van mijn half digitale leven, volgens mijn eigen wensen en voorkeuren. Want dat is het voordeel van zelf het beheer doen van je half digitale leven. Dan kun je kiezen om in sommige situaties een onnavolgbaar AI script op je data los te laten, en oms wil je wat meer inzicht in de beweegredenen van geautomatiseerde beslissingen die voor je gemaakt worden. Nauwgezet kunnen configeren wat je wel en niet wilt, dat is cruciaal. Want leven in een half digitale wereld is geen wel of niet keuze. We kunnen er niet meer aan ontsnappen, en ook niet ontkennen dat het zinvol is om algoritmes een rol te geven in ons leven, maar toch is het wel belangrijk zelf de regie te hebben. Of in elk geval te bepalen wanneer je zelf de regie wilt hebben, en wanneer niet. Deze toelichting maakt hopelijk de titel van deze verkenning een beetje duidelijker. Be Your Own Robot. Met mij als proefkonijn. Tot volgende week!